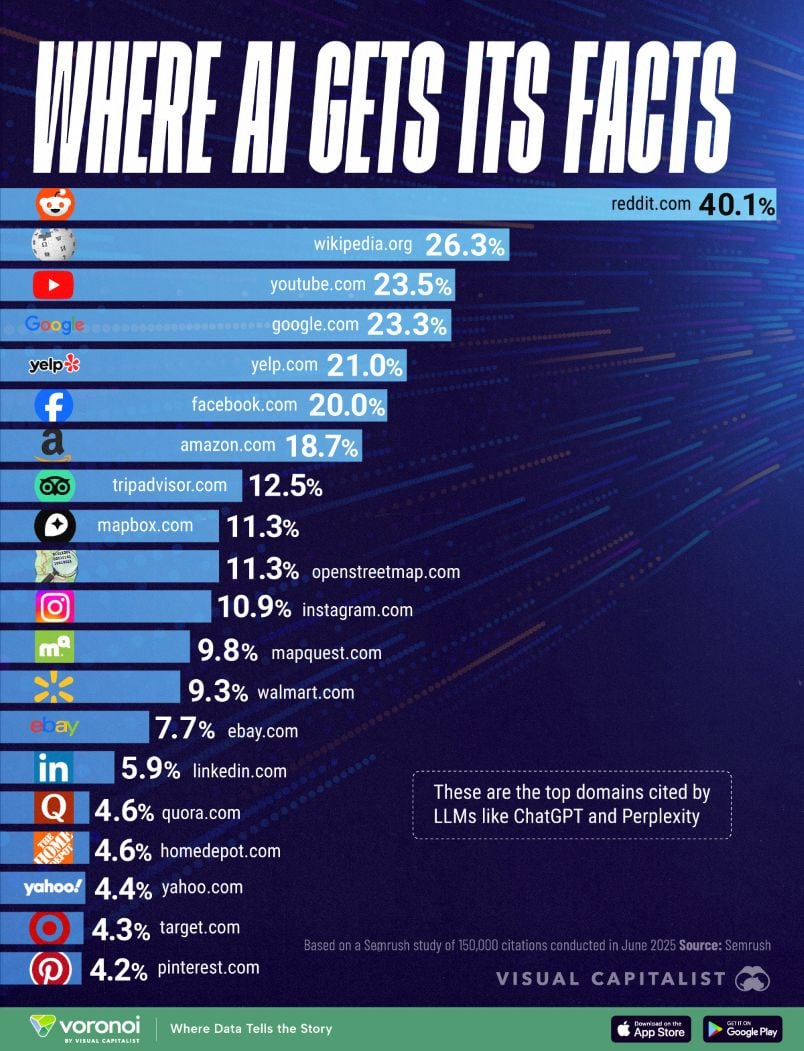

Замисляли ли сте се откъде всъщност големите езикови модели (LLM) като ChatGPT черпят фактическа информация? В инфографиката по-долу са класирани най-често цитираните уебсайтове от AI, въз основа на анализ от юни 2025 г. на над 150 000 позовавания на езикови модели. Тя разкрива колко много чатботовете разчитат на съдържание, генерирано от потребители, което повдига въпроси за слабите места на днешните най-добри AI инструменти.

Данните за тази визуализация на Visual Capitalist са от Semrush и показват колко често AI моделите цитират различни домейни, когато предоставят информация.

Reddit е начело в списъка с честота на цитиране от 40.1%, следван от Wikipedia с 26.3%. Това подчертава колко често LLM разчитат на дискусии в отворени форуми и съдържание, поддържано от общността.

Тези домейни предлагат богатство от знания, генерирани от потребителите, но отвореният им характер на редактиране повдига опасения относно точността и пристрастността. Високата зависимост показва, че AI може да усилва най-видимите или най-популярни наративи, дори и да не са винаги проверени.

Сред фрапиращите примери е предложението на ChatGPT към потребители да пречистят водата си с белина или дори да я смесят с оцет – а миксирането на хлорна белина с оцет образува хлорен газ, който е токсичен.

Три основни риска от потребителското съдържание

- Разпространение на дезинформация и слухове: Тъй като съдържанието не винаги се модерира от експерти в областта, AI може неволно да повтаря неточни или пристрастни твърдения;

- Усилване на ефекта на ехото: Популярни, но непотвърдени наративи могат да се повтарят, ако придобият популярност, като засенчват по-малко видими, но по-точни източници;

- Липса на авторитет: Особено по отношение на важни теми (здраве, право, финанси), сайтовете, създадени от потребители, не разполагат с необходимия редакционен надзор за надеждно филтриране на съдържанието.

Източник: Economic.bg